Világszerte gombamód szaporodnak az úgynevezett AI-gyárak – hatalmas adatközpontok, amelyeket nem weboldalak vagy e-mailek kiszolgálására terveztek, hanem arra, hogy mesterséges intelligenciát tanítsanak és működtessenek. A technológiai óriások milliárdokat fektettek be abba, hogy ügyfeleiknek felhőalapú AI-infrastruktúrát biztosítsanak. A vállalatok versenyt futnak, hogy létrehozzák azokat az „AI-öntödéket”, amelyekből a következő generációs termékek és szolgáltatások születnek. A kormányok sem maradnak ki: egyre több ország invesztál mesterséges intelligenciába, például személyre szabott egészségügyi megoldások vagy saját nyelvi szolgáltatások fejlesztésére.

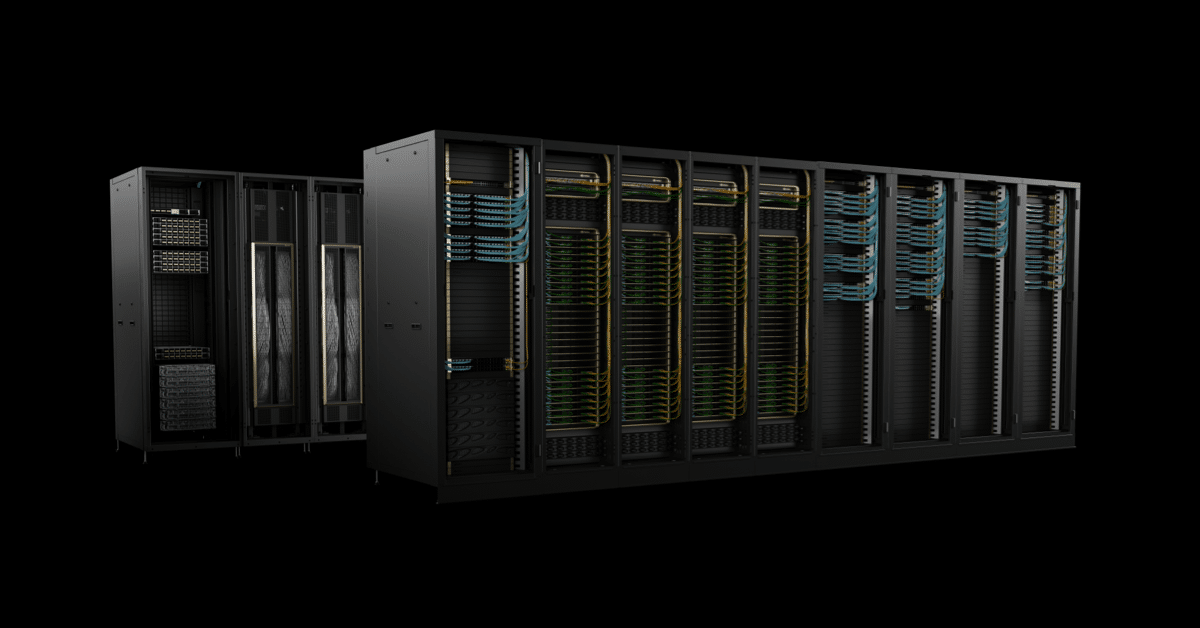

Az AI-adatgyárak korában mondhatni teljesen átírták a játékszabályokat, és a hálózat felépítése már semmiben sem hasonlít a régi internethez. Ezek bizony már nem a megszokott hiperskálázott adatközpontok. Sok esetben tíz- vagy százezernyi GPU-t fűznek össze egyetlen egységgé. Ezeket nem csak egyszerűen összerakják, hanem hangolják, vezérlik és egyben működtetik. És mi a kulcs ehhez? A hálózati kapcsolat és annak zökkenőmentes irányítása.

Ezek az adatközpontok válnak tehát a számítási kapacitás új alapegységévé, és az, hogy a GPU-k milyen módon kommunikálnak egymással, pontosan meghatározza, mire képes az egész rendszer. Egyetlen hagyományos hálózati architektúra már nem elég. Többrétegű, csúcstechnológiás felépítés szükséges – például olyan optikai megoldásokkal, amelyek néhány éve még sci-finek tűntek.

A komplexitás itt nem hiba, hanem alapvető jellemző. Az AI-infrastruktúra távol áll mindattól, amit eddig ismertünk. Ha a hálózati rétegeket rosszul tervezzük meg, a skálázás elakad, és a teljes rendszer megbénul. Ha viszont jól, akkor példátlan teljesítmény válik elérhetővé.

Ez a változás fizikailag is nyomon követhető. Egy évtizede a chipek könnyűek és kompaktak voltak. Ma viszont a csúcstechnológia több száz kilós rézgerincekből, folyadékhűtéses modulokból és speciális adatsínekből áll. Minél összetettebb modelleket kell futtatni, annál inkább nagyobbak ezek a gépek.

Vegyük például az NVIDIA NVLink gerincet: több mint 5000 koaxiális kábelből épül fel, amelyek precízen vannak összefonva és elvezetve. Ez a rendszer másodpercenként közel annyi adatot képes továbbítani, mint az egész internet forgalma – összesen 130 TB/s GPU-GPU sávszélességet, teljes összeköttetésben.

Ez nem csupán gyorsaság. Ez az alap. Az AI szupersztráda ma már a rackeken belül fut.

Az adatközpontok átalakulása

A mai nagy nyelvi modellek (LLM-ek) betanítása már régen nem arról szól, hogy egyetlen gép számol napokig. Ehhez több tízezer vagy akár százezer GPU összehangolt munkája kell, ezek végzik a nehéz számításokat.

Ezt úgy oldják meg, hogy a feladatot elosztják sok szerver között. Minden szerver (vagyis node) a munka egy szeletét dolgozza fel. A tanítás közben ezeket a szeleteket – óriási mátrixokat – folyamatosan össze kell fésülni és frissíteni. Erre szolgálnak a kollektív műveletek:

- all-reduce: minden szerver adatát összegyűjtik, majd az eredményt visszaküldik mindenkinek,

- all-to-all: minden szerver adatot cserél az összes többivel.

Ezeknél a folyamatoknál a hálózat sebessége és késleltetése létfontosságú. Ha a hálózat lassú vagy akadozik, a tanítás megáll, és az egész rendszer vesztegel.

Amikor a kész modelleket használjuk másfajta kihívások jönnek elő. Például a kereséssel kiegészített rendszerek (RAG) valós időben keresnek adatokat, és azonnal kell választ adniuk. A felhőben pedig sok ügyfél futtat egyszerre modelleket – ilyenkor a hálózatnak biztosítania kell, hogy mindenkinek gyors, zavartalan legyen a kiszolgálás.

Miért nem elég az Ethernet?

Az Ethernetet eredetileg egyszerű, egy szervert kiszolgáló feladatokra tervezték. Régen belefért, ha volt némi akadozás vagy késés az adatátvitelben. Az AI korában viszont ez már szűk keresztmetszet. A jelenlegi Ethernet-alapú switchek sem tudják mindig biztosítani a stabil, kiszámítható teljesítményt.

Az AI-hoz olyan hálózatra van szükség, amely:

- akadozás-mentes,

- kezeli a hirtelen fellépő óriási adatforgalmat,

- alacsony késleltetéssel működik,

- stabil és kiszámítható,

- és kizárja a hálózati „zajt”, vagyis az egymást zavaró adatfolyamokat.

Erre ad megoldást az InfiniBand, amelyet a szuperszámítógépeknél és AI-adatközpontoknál már iparági szabványnak tekintenek.

InfiniBand: az AI-gyárak gyorsítója

Az NVIDIA Quantum InfiniBand olyan újításokat kínál, amelyek kifejezetten az AI-hoz készültek:

- a kollektív műveleteket magában a hálózatban futtatja (SHARP protokoll), így akár duplázza az adatátvitelt,

- okosan osztja el a forgalmat (adaptív útválasztás), és figyeli a torlódásokat, hogy mindig optimális utat találjon,

- garantálja a stabil, kiszámítható sávszélességet, miközben kizárja a hálózati zajt.

Nem véletlen, hogy az NVIDIA Quantum technológiájára épül a világ szuperszámítógépeinek többsége a TOP500 listán, amely az elmúlt két évben 35%-kal bővült.

A nagyobb klaszterekhez az NVIDIA Quantum-X800 switch nyújt megoldást:

- 144 porttal rendelkezik, mindegyik 800 Gbps sebességre képes,

- beépített SHARPv4 gyorsítót tartalmaz,

- csökkenti az energiafogyasztást és a késleltetést a szilícium-fotonika alkalmazásával.

Ha mindezt kombináljuk az NVIDIA ConnectX-8 SuperNIC kártyákkal, amelyek 800 Gb/s sebességet biztosítanak GPU-nként, akkor egy olyan „hálózati szövet” jön létre, amely képes akár trillió paraméteres modellek futtatására is.

Spectrum-X: az Ethernet újratervezve

A nagyvállalatok már rengeteget költöttek az Ethernet-alapú rendszereikre, így nem válthatnak egyik napról a másikra. Nekik olyan megoldás kell, ami a meglévő ökoszisztémát használja, de bírja az AI igényeit is.

Ezért fejlesztette ki az NVIDIA a Spectrum-X-et: egy olyan AI-ra optimalizált Ethernetet, amely biztosítja a nagy teljesítményt, miközben illeszkedik a meglévő környezethez.

A Spectrum-X teljesen újragondolja az Ethernetet az AI igényeihez. 2023-as bemutatásakor a cél az volt, hogy olyan hálózatot kínáljon, amely veszteségmentes adatátvitelt, adaptív útvonalválasztást és teljesítmény-izolációt biztosít. A Spectrum-4 ASIC alapú SN5610 switch akár 800 Gb/s-os portsebességet támogat, és az NVIDIA fejlett torlódáskezelésével képes a hálózati terhelés alatt is 95%-os adatátviteli hatékonyságot fenntartani.

A Spectrum-X előnye, hogy teljes mértékben a szabványos Ethernetre épül. Támogatja a Cumulus Linuxot és a nyílt forráskódú SONiC hálózati operációs rendszert is, így a vállalatok rugalmasan építhetik be meglévő környezetükbe. A rendszer kulcselemei az NVIDIA SuperNIC-ek, amelyek az NVIDIA BlueField-3 vagy ConnectX-8 technológiára épülnek. Ezek akár 800 Gb/s RoCE kapcsolatot nyújtanak, miközben tehermentesítik a szervert a csomagok újrarendezésétől és a torlódáskezeléstől.

A Spectrum-X tulajdonképpen az InfiniBand legjobb újításait hozza át az Ethernet világába:

- telemetria-alapú torlódásvezérlés,

- adaptív terheléselosztás,

- közvetlen adat-elhelyezés (direct data placement).

Ennek köszönhetően a vállalatok százezres nagyságrendű GPU-klasztereket is képesek skálázni Etherneten. A Spectrum-X-re épülő nagy rendszerek – köztük a világ legnagyobb AI-szuperszámítógépe – 95%-os adatátvitelt értek el teljesítményromlás nélkül. Összehasonlításképpen: a hagyományos „Ethernet szövetek” a csomagütközések miatt általában csak kb. 60%-os hatékonyságot biztosítanak.

Szerteágazó hálózati portfólió az AI-feladatokhoz

Egyetlen hálózat sem képes kiszolgálni az AI-gyárak minden rétegét. Az NVIDIA megközelítése az, hogy mindig a megfelelő hálózati technológiát illeszti a megfelelő szinthez, majd ezeket szoftverrel és chipekkel összekapcsolja egyetlen egységes architektúrában.

NVLink: skálázás racken belül

Egy szerverracken belül a GPU-knak úgy kell kommunikálniuk, mintha ugyanannak a processzornak a magjai lennének. Az NVIDIA NVLink és az NVLink Switch pontosan ezt teszi lehetővé: a GPU-k memóriáját és sávszélességét több csomópont között is kiterjeszti.

Egy NVIDIA GB300 NVL72 rendszerben például 36 Grace CPU és 72 Blackwell Ultra GPU működik együtt egyetlen NVLink tartományban, amely összesen 130 TB/s sávszélességet biztosít. Az NVLink Switch segítségével ez a hálózat tovább bővíthető: egyetlen GB300 NVL72 akár 9x több GPU-t támogat, mint egy hagyományos, 8 GPU-s szerver. Az eredmény: a teljes rack egy nagy GPU-ként működik.

Fotonika: a következő ugrás

Ahhoz, hogy elérjük a millió GPU-s AI-adatközpontokat, a hálózatnak le kell győznie a csatlakoztatható optikák teljesítmény- és sűrűségkorlátait.

Az NVIDIA Quantum-X és Spectrum-X Photonics switchek közvetlenül a chipcsomagba integrálják a szilícium fotonikát, így 128–512 portot kínálnak, portonként 800 Gb/s sebességgel. Ez összesen 100–400 Tb/s sávszélességet jelent.

Az új fotonikai megoldás ráadásul 3,5× jobb energiahatékonyságot és 10× nagyobb megbízhatóságot nyújt a hagyományos optikai technológiákhoz képest – ezzel megnyitva az utat a gigawatt méretű AI-gyárakhoz.

Összegzés

Az AI-adatközpontok új korszaka nemcsak hatalmas számítási teljesítményt, hanem teljesen új hálózati gondolkodást is igényel. A hagyományos megoldások már nem bírják a terhelést: a nagy nyelvi modellek (LLM-ek), a valós idejű keresések és a több százezer GPU-t összekapcsoló rendszerek olyan szupersztrádát követelnek, amely egyszerre gyors, megbízható és rugalmas.

Az NVIDIA megoldásai – legyen szó NVLinkről, InfiniBandról, Spectrum-X Ethernetről vagy a fotonikai áttörésekről – mind ugyanazt a célt szolgálják: skálázható, stabil és jövőbiztos infrastruktúrát építeni az AI-gyárak számára.

Aki ma jól választ hálózati architektúrát, az nemcsak a jelen problémáit oldja meg, hanem biztos alapot teremt a következő generációs AI-alkalmazásokhoz.